Hallo, Technikbegeisterte und Neugierige! Willkommen zu unserem neuesten Blogbeitrag, in dem wir einen spannenden Fortschritt im Bereich der KI namens Corrective Retrieval-Augmented Generation (CRAG) vorstellen. Wenn du unseren Weg verfolgt hast, weißt du, dass wir mit Leidenschaft komplexe KI-Technologien zugänglich und in realen Anwendungen nutzbar machen wollen. Heute schauen wir uns an, wie Corrective RAG, eine weitere fortschrittliche RAG-Methode, KI-Systeme genauer und zuverlässiger machen kann.

Was ist eine RAG-Korrektur?

Im Kern ist Retrieval-Augmented Generation (RAG) eine Technik, die die Stärken des Abrufs relevanter Informationen aus einem großen Datensatz und der Generierung kohärenter Antworten mithilfe von KI-Modellen kombiniert. Corrective RAG (CRAG) geht noch einen Schritt weiter, indem es Mechanismen zur Erkennung und Korrektur von Fehlern in Echtzeit integriert, um sicherzustellen, dass die bereitgestellten Informationen nicht nur relevant, sondern auch korrekt sind.

Warum brauchen wir Korrekturmechanismen?

KI-Systeme sind unglaublich leistungsfähig, aber sie sind nicht perfekt. Hier sind ein paar häufige Probleme, mit denen sie konfrontiert werden:

- Widersprüchliche Informationen: Manchmal liefern verschiedene Datenquellen widersprüchliche Antworten. CRAG hilft, diese Konflikte zu lösen, um möglichst genaue Informationen zu liefern.

- Komplexe Fragen: Manche Fragen sind komplex und erfordern ein tieferes Verständnis, um sie richtig zu beantworten. CRAG verbessert die Fähigkeit des Systems, diese komplexen Abfragen zu bearbeiten.

- Sich entwickelndes Wissen: Wenn neue Informationen verfügbar werden, müssen KI-Systeme ihre Wissensbasis ständig aktualisieren. CRAG sorgt dafür, dass das System mit den neuesten Informationen auf dem neuesten Stand bleibt.

Wie funktioniert die RAG-Korrektur?

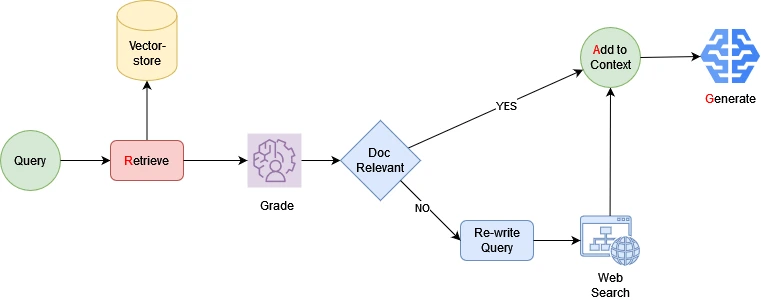

Corrective RAG integriert mehrere fortschrittliche Prozesse, um die Zuverlässigkeit und Genauigkeit der KI-generierten Antworten zu verbessern. Hier ist ein grober Überblick darüber, wie es funktioniert:

1. Relevante Informationen abrufen

Das System beginnt mit der Suche nach Dokumenten, die für die Frage des Nutzers relevant sind. Dieser erste Schritt stellt sicher, dass die KI Zugang zu den wichtigsten verfügbaren Daten hat.

2. Bewertung der Relevanz von Dokumenten

Um die Qualität der Informationen zu gewährleisten, bewertet das System die Relevanz jedes abgerufenen Dokuments. Dieser Schritt filtert weniger relevante Daten heraus und konzentriert sich auf die nützlichsten Informationen.

3. Abfragen umwandeln

Wenn die anfängliche Suche nicht genügend Informationen liefert, kann das System die Anfrage des Nutzers umwandeln, um den Suchprozess zu verbessern. Das hilft dabei, die Frage zu verfeinern, um bessere Ergebnisse zu erzielen.

4. Durchführen von Web-Suchen

Bei Bedarf führt das System eine Websuche durch, um die abgerufenen Dokumente mit den neuesten und relevantesten online verfügbaren Informationen zu ergänzen.

5. Antworten generieren

Anhand der abgerufenen Dokumente erstellt das System eine prägnante und kohärente Antwort. Dieser Prozess nutzt leistungsstarke Sprachmodelle, um menschenähnliche Antworten zu produzieren.

Die Strategie der Verwendung kleinerer, quelloffener Modelle

In unserem Ansatz nutzen wir eine Kombination aus MoE und einem kleineren Open-Source-Modell mit 7 Milliarden Parametern (7B) wie Mixtral und Mistral. Hier ist, warum diese Strategie von Vorteil ist:

- Effizienz: Kleinere Modelle benötigen weniger Rechenleistung und sind daher schneller und kostengünstiger zu betreiben. Diese Effizienz ist entscheidend für Echtzeitanwendungen, bei denen die Reaktionszeit entscheidend ist.

- Zugänglichkeit: Open-Source-Modelle sind für ein breiteres Spektrum von Nutzern und Entwicklern zugänglicher. Diese Offenheit fördert Innovation und Zusammenarbeit innerhalb der KI-Gemeinschaft.

- Flexibilität: Kleinere Modelle lassen sich leichter feinjustieren und an bestimmte Aufgaben anpassen. Diese Flexibilität ermöglicht es uns, die Modelle auf die einzigartigen Bedürfnisse unserer Anwendungen zuzuschneiden.

- Skalierbarkeit: Durch den Einsatz effizienter Modelle können wir unsere Lösungen effektiver skalieren. Diese Skalierbarkeit sorgt dafür, dass unsere Systeme steigende Lasten ohne Leistungseinbußen bewältigen können.

Vorteile der RAG-Korrekturen

- Verbesserte Genauigkeit: Durch das Erkennen und Korrigieren von Fehlern in Echtzeit verbessert CRAG die Genauigkeit der KI-Antworten erheblich.

- Erhöhte Zuverlässigkeit: Die Fähigkeit des Systems, komplexe Abfragen zu bearbeiten und seine Wissensbasis kontinuierlich zu aktualisieren, macht es sehr zuverlässig.

- Bessere Nutzererfahrung: Die Nutzer/innen erhalten relevantere und genauere Informationen, was zu einem besseren Gesamterlebnis mit KI-Systemen führt.

Fazit

Corrective RAG ist ein großer Schritt nach vorn, um KI-Systeme genauer und zuverlässiger zu machen. Durch die Integration von fortschrittlichen Feedbackschleifen, Fehlererkennungsmechanismen und Korrekturprotokollen können wir KI-Lösungen entwickeln, die nicht nur intelligent, sondern auch vertrauenswürdig sind. Durch den Einsatz kleinerer 7B-Open-Source-Modelle wie Mistral erreichen wir Effizienz, Zugänglichkeit, Flexibilität und Skalierbarkeit in unseren KI-Lösungen. Mit dieser Strategie stellen wir sicher, dass wir leistungsstarke und zuverlässige KI-Tools anbieten, die für ein breiteres Publikum zugänglich sind. Wir hoffen, dass dieser Beitrag dir ein besseres Verständnis der Korrektur-RAG und ihrer möglichen Vorteile vermittelt hat. Bleib dran für weitere Updates und Einblicke, wenn wir die aufregende Welt der KI weiter erforschen. Bis zum nächsten Mal, erforsche und erfinde weiter! Wenn du tiefer in die Materie eintauchen möchtest, schau dir unseren ausführlichen Artikel auf Medium an.