Das vergangene Jahr war ein entscheidendes Jahr für die generative KI, insbesondere in der Welt der Open-Source Large Language Models (LLMs). Wir bei ArtiQuare waren mittendrin und haben diese leistungsstarken LLMs für den praktischen, geschäftsorientierten Einsatz angepasst.

Bei unserer Arbeit geht es hauptsächlich um die Entwicklung von Systemen, die Unternehmen dabei helfen, LLMs für die Automatisierung von Aufgaben, die Recherche und die Schaffung neuen Wissens aus ihren eigenen Daten zu nutzen. Auf diesem Weg haben wir uns stark auf Retrieval-Augmented Generation (RAG) Systeme konzentriert. Die RAG hat sich zu einem wichtigen Akteur im Bereich der KI entwickelt, da sie die kreative Kraft der LLMs mit spezifischen, relevanten Informationen aus der Wirtschaft kombinieren kann.

Der Wechsel zur RAG kam nicht unerwartet. Während LLMs anfangs durch ihre Fähigkeit zu chatten und zu interagieren auffielen, wurde bald klar, dass ihr wahrer Wert in der Lösung echter Geschäftsprobleme liegt. RAG-Systeme haben sich an die Spitze dieses Wandels gestellt und sich als unglaublich nützlich für Unternehmen erwiesen, die mehr aus der KI herausholen wollen.

Auf dem Weg ins Jahr 2024 wird die Rolle der RAG bei KI-Lösungen für Unternehmen weiter wachsen. Mit Blick auf den breiteren Kontext der KI-Einführung wirft die jüngste jährliche globale CEO-Umfrage von PwC ein Licht auf die sich entwickelnde Sichtweise von Unternehmensführern auf generative KI. Obwohl die Integration dieser Technologien schrittweise erfolgt, erkennen die CEOs zunehmend die damit verbundenen Möglichkeiten. 60 % der Umfrageteilnehmer sehen in der generativen KI eher eine Chance als ein Risiko und erwarten in naher Zukunft einen größeren Einfluss. Darüber hinaus gehen 70 % der CEOs davon aus, dass generative KI in den nächsten drei Jahren nicht nur den Wettbewerb verschärfen, sondern auch Veränderungen in den Geschäftsmodellen herbeiführen und neue Qualifikationen der Mitarbeiter erfordern wird.

Dieser zukunftsorientierte Ausblick passt perfekt zu unserem Fokus auf die Anpassung von Large Language Models (LLMs) für den Unternehmenseinsatz. Während wir uns mit diesem Thema beschäftigen, sollten wir uns einen Moment Zeit nehmen, um die bedeutenden Fortschritte der generativen KI im Jahr 2023 zu rekapitulieren.

Zusammenfassung der generativen KI-Entwicklungen im Jahr 2023

2023 war ein Jahr des raschen Fortschritts im Bereich der generativen KI, geprägt von bedeutenden Fortschritten und einer wachsenden Landschaft von Open-Source-Tools und -Projekten. Das Entwicklungstempo bei den großen Sprachmodellen (Large Language Models, LLMs) war besonders bemerkenswert und spiegelt einen allgemeinen Trend zur kontinuierlichen Verbesserung und Innovation wider.

Wichtige Entwicklungen bei LLM und Ökosystemen:

- Fortschritte bei den Modellfähigkeiten: Die LLM haben nicht nur an Umfang, sondern auch an Raffinesse gewonnen und zeigen ein besseres Verständnis und bessere Generierungsfähigkeiten. Diese Verbesserungen haben neue Türen für praktische Anwendungen in verschiedenen Branchen geöffnet.

- Wachstum von Open-Source-Projekten: Im Laufe des Jahres gab es einen Aufschwung bei Open-Source-Projekten im Zusammenhang mit LLMs, der durch einen gemeinschaftsorientierten Entwicklungsansatz vorangetrieben wurde. Dieser Trend hat den Zugang zu hochmodernen KI-Technologien demokratisiert und ermöglicht es einer größeren Zahl von Entwicklern und Unternehmen, zu experimentieren und zu innovieren.

- Erweiterung des Ökosystems: Neben den Modellen selbst haben auch die Tools und Plattformen, die LLMs unterstützen, stark zugenommen. Von Hilfsprogrammen für die Datenverarbeitung bis hin zu benutzerfreundlichen Schnittstellen ist das Ökosystem, das die LLM umgibt, reichhaltiger und für die praktische Anwendung förderlicher geworden.

- Aufstieg der multimodalen KI: Das Aufkommen und Wachstum der multimodalen KI war ein bedeutender Schritt. Diese Systeme, die in der Lage sind, verschiedene Arten von Daten (wie Text, Bilder und Audio) zu verarbeiten und zu integrieren, haben ein großes Potenzial für die Entwicklung vielseitiger und kontextbezogener KI-Lösungen.

Nachdem wir uns mit den allgemeinen Branchentrends befasst haben, wenden wir uns nun der Frage zu, wie sich diese Entwicklungen auf den Unternehmenssektor auswirken.

Anpassung von LLMs in Unternehmen:

Die Anpassung von LLMs in Unternehmen ist ein hervorstechender Trend. Die Unternehmen haben das Potenzial dieser Modelle für die Automatisierung von Prozessen, die Unterstützung der Forschung und die Gewinnung neuer Erkenntnisse zunehmend erkannt. In unserer Arbeit bedeutete die Anpassung von LLMs oft die Konstruktion von RAG-Systemen, die unternehmensspezifische Daten effektiv nutzen können, um KI-Tools nicht nur leistungsfähig, sondern auch relevant und praktisch für die Bedürfnisse von Unternehmen zu machen.

Der Aufstieg von RAG als vorherrschende architektonische Wahl ging einher mit einer wachsenden Nachfrage nach KI-Lösungen, die auf das Geschäft ausgerichtet sind. Im Gegensatz zu den Anfängen der LLMs, bei denen die Aufregung vor allem um ihre Fähigkeit ging, Konversation zu simulieren, hat sich der Schwerpunkt jetzt auf die Nutzung dieser Modelle für tiefergehende, substanziellere Unternehmensanwendungen verlagert.

Wenn wir das vergangene Jahr Revue passieren lassen, wird klar, dass die Reise mit generativer KI und RAG-Systemen gerade erst begonnen hat. Die Fortschritte im Jahr 2023 haben die Weichen für noch innovativere und wirkungsvollere Anwendungen im kommenden Jahr gestellt.

Lassen Sie uns erkunden, wie diese fortschrittlichen KI-Tools auf spezifische, komplexe Geschäftsanforderungen zugeschnitten werden können, um neue Wege für Innovation und Wettbewerbsvorteile zu erschließen.

Schwerpunkt auf LLM-Anpassung für den Einsatz in Unternehmen

In der dynamischen Landschaft der generativen KI ist einer der wichtigsten Trends die Adaption von Large Language Models (LLMs) durch Unternehmen für ihre proprietären und internen Daten. Dieser Trend zur Anpassung von LLMs wird durch die Notwendigkeit angetrieben, KI für spezifische, oft komplexe Geschäftsanforderungen zu nutzen.

1. Warum Unternehmen sich der LLM-Anpassung zuwenden:

- Unternehmen wollen sich die Leistungsfähigkeit von LLMs zunutze machen, um ihre einzigartigen Datenbestände zu verarbeiten, zu analysieren und Erkenntnisse zu gewinnen.

- Ziel ist es, KI-Lösungen zu schaffen, die nicht nur in Bezug auf die reine Rechenleistung leistungsfähig sind, sondern auch genau auf den spezifischen Unternehmenskontext und die Anforderungen abgestimmt sind.

2. Haupttechniken der LLM-Anpassung:

- Feinabstimmung: Anpassen von vorab trainierten Modellen, um sie besser an bestimmte Daten oder Aufgaben anzupassen, obwohl dies ressourcenintensiv sein kann.

- Prompt-Engineering: Die Entwicklung von Prompts, die das Modell effektiv anleiten, die gewünschten Ergebnisse zu erzielen, ist eine Technik, die aufgrund ihrer Effizienz und Einfachheit weit verbreitet ist.

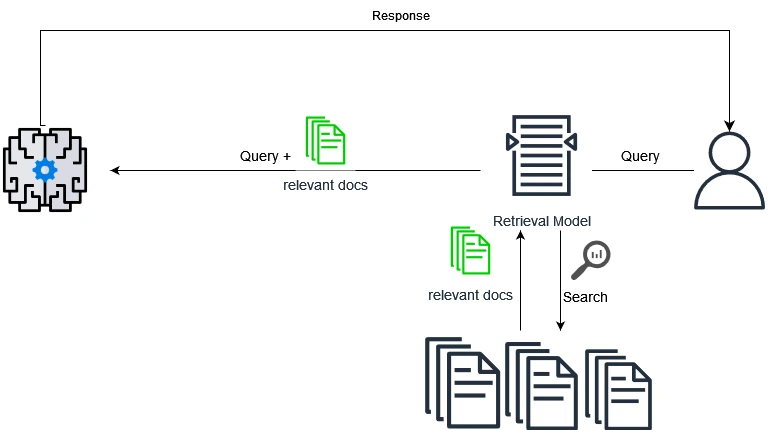

- Retrieval-Augmented Generation (RAG): Eine Technik, die die generativen Fähigkeiten von LLMs mit externem Datenabruf kombiniert und sich besonders für Aufgaben eignet, die eine Kombination aus allgemeinem Wissen und spezifischen, domänenrelevanten Informationen erfordern.

3. Unsere Erfahrungen mit der LLM-Anpassung:

- Wir haben ausgiebig mit diesen Techniken gearbeitet, sie bei verschiedenen Projekten angewandt und ihr Potenzial und ihre Grenzen aus erster Hand kennengelernt.

- Unsere Reise hat gezeigt, dass die Feinabstimmung zwar Präzision bietet, dass aber die kostengünstigsten und vielseitigsten Lösungen für Unternehmensanwendungen oft durch prompte Entwicklung und RAG erzielt werden.

4. Die wachsende Bedeutung von maßgeschneiderten KI-Lösungen:

- Dieser Trend zur LLM-Anpassung unterstreicht eine breitere Verlagerung in der KI-Branche: weg von Einheitsmodellen hin zu maßgeschneiderten Lösungen, die auf die einzigartigen Herausforderungen und Möglichkeiten der einzelnen Unternehmen eingehen.

Unsere Erfahrungen mit verschiedenen Kundenprojekten und KI-Herausforderungen haben nicht nur unsere Fähigkeiten geschärft, sondern uns auch gezeigt, wie die RAG das Spiel für Unternehmen verändert. Nach der anfänglichen Aufregung um KI-Gespräche ist RAG nun ein Werkzeug für ernsthafte, wirkungsvolle Geschäftsanwendungen. Wenn wir über die praktischen Anwendungen dieser Fortschritte nachdenken, wird die Entwicklung von RAG-Systemen zu einem wichtigen Schwerpunktbereich.

Der Aufstieg und die Entwicklung von Retrieval-unterstützten Generierungssystemen

Die Popularität von RAG-Systemen verstehen

Im Jahr 2023 wurden Retrieval-Augmented Generation (RAG) -Systeme zunehmend zur bevorzugten Architektur für viele KI-Anwendungen, insbesondere in Unternehmen. Dieser Trend wurde durch die klare Erkenntnis getrieben, dass sie das Potenzial haben, gezieltere und relevantere KI-gestützte Lösungen anzubieten.

RAG Systems im Rampenlicht:

- RAG-Systeme, die die generativen Fähigkeiten von LLMs mit der Fähigkeit kombinieren, spezifische, relevante Informationen einzuholen, erwiesen sich als ideal für verschiedene Geschäftsanwendungen.

- Ihre Fähigkeit, auf externe Datenquellen zu verweisen und diese zu nutzen, machte sie besonders attraktiv für Aufgaben, die Tiefe und Spezifität erfordern und die Fähigkeiten von eigenständigen Gesprächsmodellen übersteigen.

- Das Konzept der „Naiven RAG“ – die einfache Vektorisierung von Dokumenten und deren Abfrage mit LLMs – gewann aufgrund seiner Einfachheit zunächst an Zugkraft. Ihre Grenzen wurden jedoch bei komplexen Szenarien mit großen Datensätzen und anspruchsvollen Abfragen deutlich.

Um die Herausforderungen und Grenzen naiver RAG-Systeme vollständig zu verstehen, ist es zunächst wichtig, ihre Funktionsweise auf einer grundlegenden Ebene zu begreifen. Der naive RAG-Prozess kann in drei Hauptphasen unterteilt werden: Abruf, Ergänzung und Erzeugung.

1. Abrufphase:

- Beschreibung: In dieser Phase durchsucht das RAG-System eine Datenbank oder eine Reihe von Dokumenten, um Informationen zu finden, die für eine bestimmte Anfrage relevant sind. Dies geschieht in der Regel durch eine vektorielle Ähnlichkeitssuche, bei der die Anfrage und die Dokumente in Vektoren (numerische Darstellungen) umgewandelt und verglichen werden.

- Einschränkung: Die Abfragephase in naiven RAG-Systemen stützt sich häufig auf vereinfachende Abgleichtechniken, was dazu führen kann, dass irrelevante oder oberflächliche Informationen abgerufen werden, insbesondere bei komplexen Abfragen.

2. Erweiterungsphase:

- Beschreibung: Die abgerufenen Informationen werden dann verarbeitet und zur Ergänzung der Antwortgenerierung aufbereitet. Dies kann eine Zusammenfassung oder Kontextualisierung der Daten beinhalten.

- Einschränkung: Naive RAG-Systeme können Schwierigkeiten haben, die abgerufenen Daten richtig zu kontextualisieren oder zu synthetisieren, was zu einer Erweiterung führt, der es an Tiefe mangelt oder die die Nuancen der Abfrage nicht genau berücksichtigt.

3. Erzeugungsphase:

- Beschreibung: Schließlich werden die erweiterten Daten in ein Sprachmodell eingespeist, das eine Antwort auf der Grundlage sowohl der ursprünglichen Anfrage als auch des zusätzlichen Kontexts, der durch die abgerufenen Daten bereitgestellt wird, erzeugt.

- Einschränkung: Wenn die abgerufenen Daten fehlerhaft oder die Ergänzung unzureichend ist, kann die Generierungsphase Antworten hervorbringen, die irreführend, unvollständig oder kontextuell unzutreffend sind.

Um die Struktur von RAG-Systemen zu verstehen, müssen auch ihre Grenzen untersucht werden, insbesondere in ihren einfacheren oder „naiven“ Formen.

Eingehender Blick auf die Grenzen und Probleme der naiven RAG

Naive RAG-Systeme sind zwar innovativ in ihrem Ansatz, Retrieval mit generativen Modellen zu kombinieren, liefern aber oft keine präzisen und kontextuell relevanten Ergebnisse, insbesondere in komplexen Unternehmensszenarien.

- Probleme bei der Datenbeschaffung: Probleme in der Abrufphase, wie ungenaue oder oberflächliche Datenabrufe, bilden eine schwache Grundlage für den gesamten Prozess.

- Herausforderungen bei der Datenerweiterung: Eine unzureichende Ergänzung kann die Lücke zwischen den Rohdaten und dem für eine präzise Antwortgenerierung erforderlichen kontextuellen Verständnis nicht schließen.

- Unzulänglichkeiten bei der Erzeugung: Die endgültige Ausgabe kann durch frühere Fehler beeinträchtigt werden, was zu Antworten führt, die nicht wirklich den Bedürfnissen oder Erwartungen des Benutzers entsprechen.

Herausforderungen beim Retrieval in einfachen RAG-Systemen

Beim Einsatz von naiven RAG-Systemen in Unternehmen ist es wichtig zu verstehen, wo sie versagen könnten, insbesondere in der ersten Abrufphase. In dieser Phase geht es darum, wie das System Informationen findet und verwendet, um eine Anfrage zu beantworten. Lassen Sie uns diese Herausforderungen in einfachere, verwaltungsfreundliche Begriffe fassen:

1. Verschiedene Bedeutungen verwechseln:

- Was passiert: Das System kann bei Wörtern mit mehreren Bedeutungen (z. B. „Apfel“ als Frucht oder als Unternehmen) verwirrt werden und falsche Informationen abrufen.

- Auswirkungen auf das Geschäft: Sie erhalten Antworten, die nicht zum Thema passen, was irreführend oder nicht hilfreich sein kann.

2. Abgleich auf der Grundlage falscher Kriterien:

- Was passiert: Das System gleicht manchmal auf der Grundlage allgemeiner Ähnlichkeiten ab und übersieht dabei die Besonderheiten dessen, wonach Sie wirklich suchen (z. B. den richtigen Ausdruck „Retrieval-Augmented Generation (RAG)“ im falschen Dokument).

- Auswirkungen auf das Geschäft: Die Antworten, die Sie erhalten, scheinen auf den ersten Blick zusammenhängend zu sein, gehen aber nicht wirklich auf Ihre spezifische Anfrage ein.

3. Schwierigkeit, enge Übereinstimmungen zu finden:

- Was passiert: In einem großen Datenpool kann das System Schwierigkeiten haben, zwischen eng verwandten Themen zu unterscheiden, was zu weniger genauen Übereinstimmungen führt.

- Auswirkungen auf das Geschäft: Sie erhalten Antworten, die zwar richtig erscheinen, aber in Wirklichkeit nichts mit Ihrer Anfrage zu tun haben.

4. Der Kontext fehlt:

- Was passiert: Das System vernachlässigt oft die feineren, kontextbezogenen Details einer Anfrage und konzentriert sich nur auf das Gesamtbild.

- Auswirkungen auf das Geschäft: Das Fehlen eines differenzierten Verständnisses führt zu Antworten, die die Absicht der Anfrage nicht vollständig erfassen.

5. Herausforderungen bei Nischenthemen:

- Was passiert: Bei sehr spezifischen oder Nischenabfragen kann es vorkommen, dass das System nicht in der Lage ist, alle relevanten Informationen aus verschiedenen Quellen zu sammeln.

- Auswirkungen auf das Geschäft: Dies kann besonders problematisch sein, wenn es sich um spezielle oder technische Anfragen handelt, die zu unvollständigen oder oberflächlichen Antworten führen.

Herausforderungen bei der Erweiterung verringern Kohärenz und Relevanz

Nach der Retrievalphase in einem naiven RAG-System stellt die Augmentierungsphase eine eigene Herausforderung dar. Hier versucht das System, die abgerufenen Informationen zu einer kohärenten und relevanten Antwort zusammenzufassen. Lassen Sie uns diese Fragen und ihre Auswirkungen auf Geschäftsanwendungen untersuchen:

1. Reibungslose Integration des Kontextes:

- Herausforderung: Das System hat möglicherweise Schwierigkeiten, den Kontext der abgerufenen Daten mit der Generierungsaufgabe zu verbinden, was zu unzusammenhängenden Ergebnissen führt.

- Beispiel: Die Vermischung von detaillierter Geschichte mit aktuellen Anwendungen der „Künstlichen Intelligenz“ könnte zu einer unausgewogenen Gewichtung führen, die den Kern der Aufgabe vernachlässigt.

2. Redundanz und Wiederholung:

- Herausforderung: Wiederholungen können auftreten, wenn mehrere Quellen ähnliche Informationen liefern, was zu redundantem Inhalt in der Ausgabe führt.

- Beispiel: Die wiederholte Erwähnung von „Retrieval Augemented Generation“ kann dazu führen, dass die Antwort repetitiv erscheint, was ihre Wirksamkeit verringert.

3. Priorisierung relevanter Informationen:

- Herausforderung: Eine effektive Einstufung der Bedeutung der verschiedenen abgerufenen Informationen ist schwierig, aber für eine genaue Ausgabe unerlässlich.

- Beispiel: Die Unterbetonung wichtiger Punkte wie „Suchindex“ zugunsten weniger wichtiger Informationen kann die Relevanz der Antwort verzerren.

4. Harmonisierung verschiedener Stile und Töne:

- Herausforderung: Die abgerufenen Inhalte können unterschiedliche Stile oder Farbtöne aufweisen, die das System für eine einheitliche Ausgabe harmonisieren muss.

- Beispiel: Eine Mischung aus legeren und formellen Tönen im Ausgangsmaterial kann zu einem uneinheitlichen Stil in der erstellten Antwort führen.

Komplexität in der Generierungsphase der Retrieval-Augmented Generation

Die letzte Phase in einem naiven RAG-System, die Generierung, stellt eine eigene Herausforderung dar. An dieser Stelle synthetisiert das System die abgerufenen und ergänzten Daten, um eine endgültige Antwort zu geben. Im Folgenden werden die in dieser Phase häufig auftretenden Probleme und ihre Auswirkungen erläutert.

1. Kohärenz und Konsistenz:

- Die Herausforderung: Es ist schwierig, logische Kohärenz und erzählerische Konsistenz aufrechtzuerhalten, vor allem, wenn unterschiedliche Informationen integriert werden.

- Beispiel: Ein abrupter Wechsel von der Erörterung von Python im Bereich des maschinellen Lernens zur Webentwicklung ohne Übergang kann die Leser verwirren.

2. Übergeneralisierung:

- Herausforderung: Das Modell kann generische Antworten anstelle von spezifischen, detaillierten Informationen liefern.

- Beispiel: Eine allgemeine Antwort auf eine Anfrage über die Unterschiede zwischen PyTorch und TensorFlow geht nicht auf die Spezifika der Anfrage ein.

3. Fehlerfortpflanzung aus dem Retrieval:

- Herausforderung: Etwaige Ungenauigkeiten oder Verzerrungen in den abgerufenen Daten können sich in der endgültigen Ausgabe noch verstärken.

- Beispiel: Eine falsche Angabe im abgerufenen Inhalt (z. B. „LlamaIndex ist ein ML Model Serving Framework“) kann die Generierungsphase in die Irre führen.

4. Versäumnis, Widersprüche anzusprechen:

- Herausforderung: Widersprüchliche Informationen in abgerufenen Daten können den Generierungsprozess verwirren.

- Beispiel: Widersprüchliche Aussagen über die Verwendung von PyTorch in der Forschung und in der Produktion können den Leser in die Irre führen, wenn sie nicht geklärt werden.

5. Unkenntnis des Kontexts:

- Herausforderung: Das Modell könnte den breiteren Kontext oder die Absicht einer Abfrage übersehen oder falsch interpretieren.

- Beispiel: Beantwortung einer Anfrage nach einem lustigen Fakt über maschinelles Lernen mit einem sehr technischen Punkt.

In Anbetracht dieser festgestellten Probleme mit naiven RAG-Systemen wird klar, warum es eine zunehmende Verlagerung hin zu anspruchsvolleren, fortschrittlichen RAG-Lösungen gibt.

Die Notwendigkeit einer fortgeschrittenen Retrieval-Augmented Generation (RAG)

Zum Abschluss unserer Untersuchung der grundlegenden oder naiven RAG-Systeme wird deutlich, dass diese Systeme zwar einen bedeutenden Fortschritt in der KI darstellen, aber nicht ohne Einschränkungen sind. Die Herausforderungen in den Phasen des Abrufs, der Erweiterung und der Generierung behindern oft ihre Effektivität, insbesondere bei komplexen, realen Unternehmensanwendungen. Diese Einschränkungen lassen sich wie folgt zusammenfassen:

- Probleme beim Abrufen von Daten: Probleme mit semantischer Mehrdeutigkeit, Unstimmigkeiten bei der Granularität und globalen bzw. lokalen Ähnlichkeiten, die zu ungenauen oder irrelevanten Datenabfragen führen.

- Herausforderungen bei der Erweiterung: Schwierigkeiten bei der Integration von Kontexten, der Handhabung von Redundanzen und der Priorisierung von Informationen, was zu unzusammenhängenden oder oberflächlichen Inhalten führt.

- Unzulänglichkeiten bei der Generierung: Probleme mit der Kohärenz, Konsistenz, Ausführlichkeit und mangelnder Tiefe, was zu Antworten führt, die den differenzierten Anforderungen von Geschäftsanfragen nicht gerecht werden.

Diese Herausforderungen unterstreichen die Notwendigkeit eines ausgefeilteren Ansatzes – der Bereich der fortgeschrittenen RAG-Systeme. Advanced RAG geht diese Einschränkungen direkt an, indem es verfeinerte Techniken und Methoden einsetzt, um eine höhere Genauigkeit, Relevanz und kontextuelle Ausrichtung der generierten Inhalte zu gewährleisten.

Einführung in die Serie über fortgeschrittene RAG-Techniken: Angesichts dieser Herausforderungen freuen wir uns, eine neue Serie ankündigen zu können, die sich mit der Welt der fortgeschrittenen RAG-Systeme befasst. In dieser Reihe wird untersucht:

- Verbesserte Abrufmechanismen: Wie fortgeschrittene RAG-Systeme eine präzisere und kontextbezogene Datenabfrage erreichen.

- Ausgefeilte Erweiterungsstrategien: Techniken zur besseren Integration und Synthese der abgerufenen Informationen.

- Verfeinerte Generierungsprozesse: Wege zur Sicherstellung von Kohärenz, Tiefe und Aufschlussreichtum in den endgültig generierten Inhalten.

Fortgeschrittene RAG-Systeme stellen die Spitze der KI-Fähigkeiten bei der Verarbeitung und Erzeugung von Wissen dar. Sie versprechen, die Art und Weise, wie Unternehmen mit KI interagieren und sie nutzen, zu verändern, indem sie über die Grenzen der einfachen RAG hinausgehen und Lösungen anbieten, die nicht nur technisch fortschrittlich, sondern auch hochgradig maßgeschneidert und effektiv für spezifische Geschäftsanforderungen sind.

Bleiben Sie dran, wenn wir uns auf diese aufregende Reise zu den fortschrittlichen RAG-Systemen begeben und ihr Potenzial entdecken, Branchen zu revolutionieren und die Zukunft der generativen KI neu zu definieren.